Abstract

深度神经网络功能强大,但是存在一些不良行为例如记忆性和对对抗样本的敏感性。(it:关注点偏移,趋向简单规则+对异常分布敏感)

Mixup给神经网络增加了正则信息,使网络在训练样本中和训练样本之间的简单线性表现中获得收益。

Introduction

在大多数成功的深度学习实践中,存在两个共性。首先,他们追求在训练数据上的经验风险最小化原则ERM(与之对应的是结构风险最小化SRM,即防止过拟合提出的策略)。其次,这些网络的规模与训练数据的数量呈线性比例关系,CIFAR-10数据集的图像为5·10^4,参数数量为10^6;ImageNet数据集的图像为10^6,参数量为10^8;One Billion Word数据集的字符有10^9,模型参数量为2·10^10。而奇怪的是学习理论( learning theory, Vapnik & Chervonenkis, 1971)的经典结果是说只要神经网络的规模(即参数量或VC复杂度)不随着训练数据的数量增加而增加,就可以保证经验风险的收敛性。

这一矛盾使得当前大部分研究所使用的ERM训练的神经网络模型的稳定性被质疑。一方面,ERM使得神经网络即使在有强正则项(或标签随机分配的分类问题?)的情况下依然记忆训练数据,而不是提炼概念。另一方面,ERM训练出的神经网络在遇到不同于训练数据分布的例子时会产生剧烈波动,即对抗性数据(adversarial examples)。这说明ERM无法在与训练数据仅有略微不同的测试数据上提供概括能力,那么应该如何替代ERM呢?——数据增强

贡献

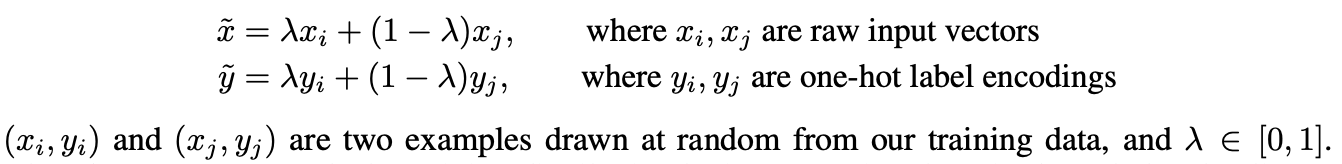

因此本文提出一种简单的数据无关的增强方式,叫做Mixup,在各项任务中都有作用。

从ERM到mixup

- 初步试验表明,使用更多图片进行狄利克雷加权混合不会提供更多增益,仅仅增加了计算量

- 当前实验的方式是加载一个batch的图像,然后打乱顺序两两混合,这样既降低了IO开销效果也一样好

- 相同标签的图像混合不会带来增益

- α∈[0.1, 0.4]会产生增益,α越大会使网络欠拟合,同时更强的模型和更长的训练轮数能从mixup中获得更多增益。

Mixup的作用

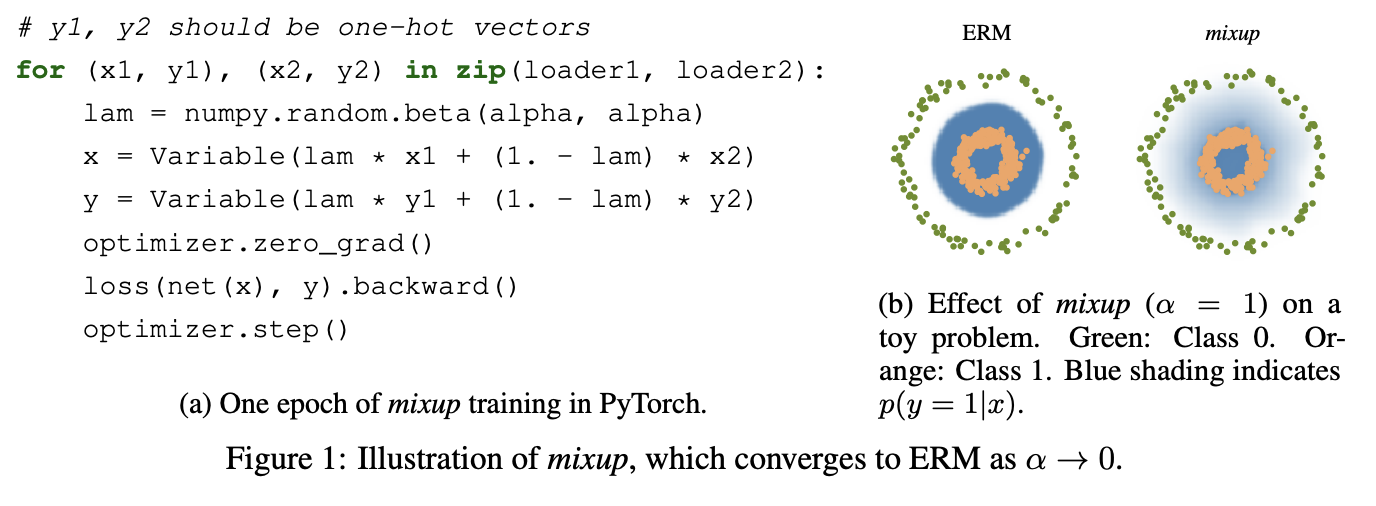

mixup可以理解为使模型线性量化两个图片的图像增强方式,而线性量化降低了模型面对其他数据时的震荡,同时从奥卡姆剃刀定律来看,线性回归是一种最简单的行为,也是一种很好的归纳偏差的方法。

图1b表明mixup在类与类之间提供了更平滑的线性过渡。

图2的两种模型具有相同的架构,使用相同的程序进行训练,并随机采样相同的训练数据进行评估,mixup比ERM的模型在预测结果更稳定,梯度范数更低。(it:测试集使用mixup方式生成,必然天生有利于使用mixup方式训练出的模型,此处论证不够完善)

Experiments

- mixup比ERM更好

- mixup使训练精度提升

- mixup可以在语音数据上使用

- 标签置信度的记忆实验:ERM比dropout有更强的能力,且两者配合能力叠加;标签置信度越低,dropout值需越高(0.8),mixup值需越高(α=32),组合时dropout(0.3)+mixup(α=8)

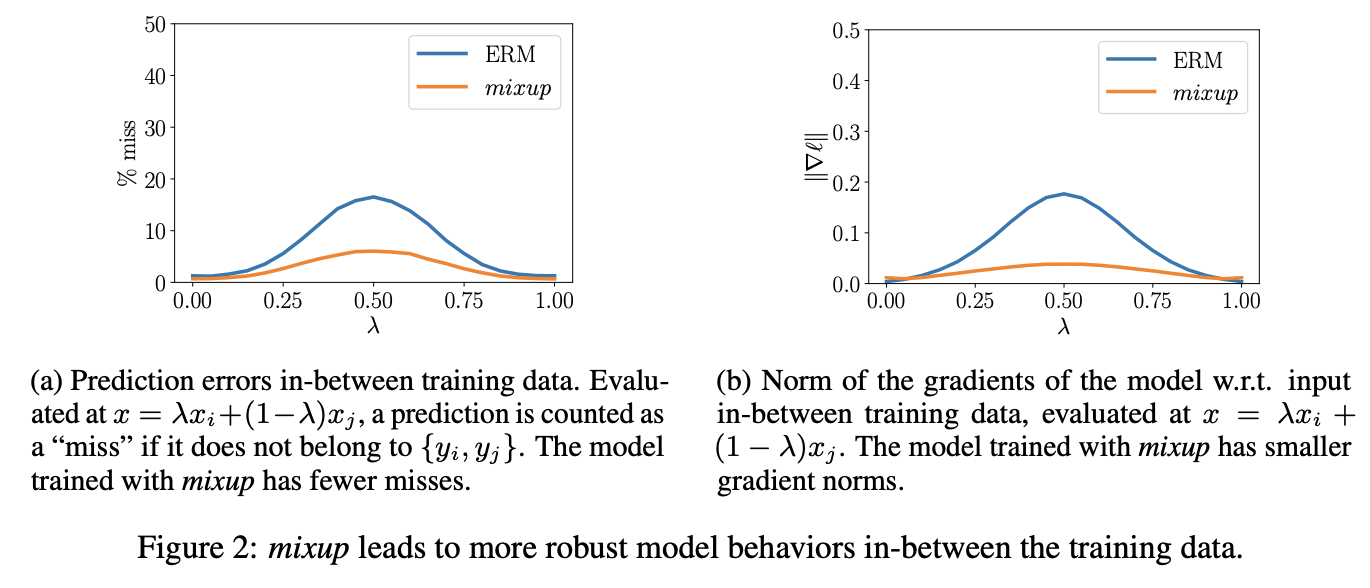

- 对抗性样本的鲁棒性:对正例增加视觉不可见的微小干扰破坏模型表现,微小干扰生成于模型对正例的梯度传导至图像,增加模型对对抗性样本的鲁棒性这属于active research。实验一,对每个像素进行最大ξ=4的浮动,进行10轮;实验二,基于ERM模型生成对抗性样本,在另一个ERM模型和mixup模型上测试。

- mixup在非图像数据上的分类效果比ERM强

- mixup在GAN模型上的表现比ERM好得多

![[翻译] Deep High-Resolution Representation Learning for Human Pose Estimation](https://blog.mclover.cn/wp-content/themes/slanted/img/thumb-medium.png)