原文链接

这是一篇可在图像领域通用的小trick,同时也是一种细粒度算法的设计。

摘要

使用基于人体局部图像的特征对行人图像进行描述为任务提供了细粒度的信息,并且在最近的文献中已被证实对于行人重识别是有益的。发现局部细粒度特征的先决条件是每个局部都应该被准确的定位。本文不使用额外标注(例如姿势估计)来直接定位局部位置,而是强调每个局部位置的内容一致性。具体来说,我们的目标是学习用于人物检索的区别性特征,并做出两个贡献。(i)Part-based Convolutional Baseline(PCB网络)。给定图像输入,它输出由若干局部级特征组成的卷积描述符。 通过统一的分块策略,PCB利用最先进的方法获得了有竞争力的结果,证明了自己是行人检索的强大卷积baseline。(ii)refined part poolingmethod (RPP方法) 统一分割图像会不可避免地在每个局部中产生异常值,这些异常值实际上与其他局部更相似。RPP重新分割图像,将这些异常值分配到最相似的局部,从而增强每个局部的一致性。实验证实,RPP将使PCB精度再一次提升。例如,在Market-1501数据集上,我们实现了(77.4+4.2)%mAP和(92.3+1.5)%rank-1准确度,大大超过了现有技术水平。

一、介绍

行人检索,也称为行人重识别(re-ID),旨在给定人员特征的情况下检索大型数据库中的给定人员的图像。 目前,深度学习方法在这个社区占主导地位,对竞争对手手工制作的模型具有令人信服的优势[40]。深度学习的表达提供了高度的辨别能力,尤其是在深度学习的部分特征汇总时。有关re-ID基准测试的最新技术水平是通过局部信息的抽象特征实现的。

学习细粒度局部特征的一个必要先决条件是局部应准确定位。目前最先进的方法因其分区策略可分为两组。第一组[38,27,31]利用额外信息,例如人类姿势估计的最新进展[23,32,15,25,2]。它们依赖于外部人体姿势估计数据集和复杂的姿势估计器。姿势估计和行人检索之间的基础数据集偏差仍然是对人物图像上的理想语义划分的障碍。另一组[35,37,22]放弃了语义部分的线索。它们不需要部件标签 1 arXiv:1711.09349v3 [cs.CV] 9 Jan 2018 ,但仍然在精确度上与第一组的不相上下。

[略]

二、相关工作

[略]

三、PCB

3.1 PCB的结构

骨干网络

PCB可以采用任何没有用于图像最终分类的隐藏全连接层的网络作为主干,例如Google Inception [29]和ResNet [13]。本文采用ResNet50,因为其富有竞争力的表现和相对简洁的架构。

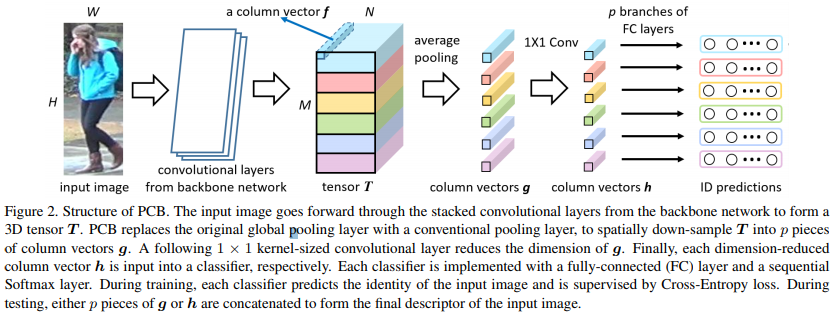

从骨干网络到PCB

我们通过略微修改将骨干网接入到PCB,如图2所示。原全局平均池化层(GAP)之前的结构与骨干模型保持完全相同。不同之处在于删除了GAP层和后面的层。当图像通过骨干网络的所有层后,它变为激活的3D张量T。在本文中,我们将沿通道轴观察的激活矢量定义为列矢量。然后将T划分为p个水平条带,使用平均池化,将同一条带中的所有列向量平均池化为单个局部列向量g。之后,PCB采用卷积层来减小g的尺寸。 根据我们的初步实验,尺寸减小的列向量h被设置为256-dim。 最后,将每个h输入到分类器中,这是通过全连接(FC)层和后续Softmax函数实现的,用于预测输入所属的标识(ID)。

在训练期间,通过最小化p个预测ID的交叉熵损失之和来优化PCB。在测试过程中,将p个g或h连接起来形成最终描述符G或H,即 G=[g1,g2,…,gp] or H=[h1,h2,…,hp]。正如在我们的实验中观察到的那样,采用G实现了稍高的精度,但计算成本更高,这与[28]中的观察结果一致。

3.2 重要参数

[略]

PCB通过去除骨干网络中的最后一次空间下采样操作来增加T的大小,从而取得了成功。

• 输入图像尺寸 384 × 128,高宽比 3:1,经过骨干网络后为12 x 4(32倍缩放,但作者在3.2中去除了骨干网络最后一层的pooling,所以输出也可能是24 x 8)

• T 的空间尺寸为 24 × 8.

• T 被分为6片

3.3 潜在的替代结构

给定相同的骨干网络,存在若干可能的替代结构来学习局部特征。我们列举了两种结构与PCB进行比较。

变体1 不是基于每个hi(i=1,2,…,p)进行ID预测,而是将所有hi平均为一个h,然后将其全连接到ID预测向量。在测试期间,连接g或h以形成最终描述符。变体1的特征在于在单个loss下学习卷积描述符。

变体2 它采用与图2中的PCB完全相同的结构。但是,变体2中FC分类器的所有分支共享一组相同的参数。

两种变体都经过实验证明不如PCB。PCB对变体1的优越性表明,不仅卷积描述符本身,而且每个局部的相应监督对于学习有区别的局部特征至关重要。PCB与变体2的优越性表明,共享分类器的权重,同时降低过度拟合的风险,会损害模型局部特征的判别能力。实验细节将在5.3节中展示。

四、RRP

4.1 局部内部的不一致

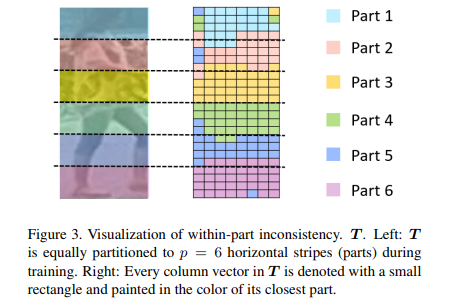

在关注空间上划分的张量T时,我们对于局部内部的不一致的想法是:在T的同一个局部中的列向量f应该彼此相似并且与其他部分中的列向量不同; 否则会发生局部内部的不一致现象,这意味着局部分割不当。

在对PCB进行收敛训练之后,我们通过测量余弦距离来比较每个 f 和 gi(即每个条带的平均池化合并列向量 i=1,2,…,p)之间的相似性。如果 f 最接近 gi,则相应地推断f最接近第i个部分。这样我们找到每个f最接近的部分,如图3所示。每个列向量用一个小矩形表示,并用其最接近部分的颜色绘制。

观察到两种现象。首先,同一水平条带中的大多数列向量都聚集在一起(尽管没有明确的约束来描述此效果)。其次,存在许多在训练期间指定到某水平条带的异常值,与另一部分水平条带更接近。这些异常值的存在表明它们本质上与另一部分中的列向量更加一致。

4.2 重新定位异常值

我们提出RPP以纠正局部内部不一致现象。我们的目标是根据它们与每个部分的相似性来分配所有列向量,以便重新分配异常值位置。

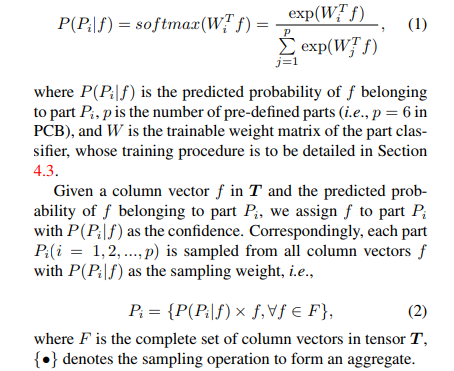

为此,我们需要在运行中对T中的所有列向量f进行分类。基于已经学习的T,我们使用线性层+Softmax激活器作为局部分类器,如下所示:

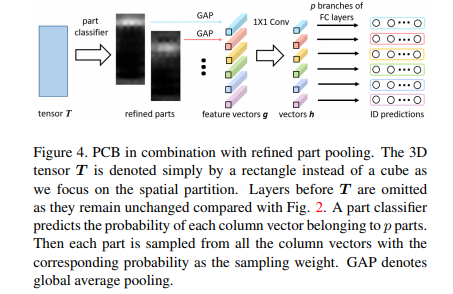

通过这样做,RPP实现了soft和自适应分区以细化原始的hard和均匀分区,并且将源自固定分区的异常值重新分配。结合RPP后,PCB进一步变形如图4。RPP+采样操作取代了原始的平均池化。所有其他层的结构与图2中的结构完全相同。

4.3 局部分类器的Induced training(诱导训练?)

在Eq.1中,局部分类器的可学习 W 缺乏明确的监督信息。我们设计了一个诱导训练程序,如Alg.1所示。

Algorithm 1: Induced training for part classifier

Step 1. 对标准PCB模型进行训练得到T,以便在均匀分割的情况下进行收敛。

Step 2. 在T之后删除原始的平均池化层,并在T上附加 p 类别的局部分类器。

Step 3. 固

定所有PCB层,仅训练局部分类器是直到再次收敛。在这种情况下,模型仍然期望张量T被均匀分区,否则它对训练图像的识别产生错误。因此Step 3惩罚局部分类器,直到它接近原始均匀分区的分区,同时倾向于将相似的列向量分到相同的区域。

Step 4. 允许更新所有图层。整个网络,即PCB以及局部分类器都经过微调,以进行整体优化。

在上述训练过程中,在Step 1中训练的PCB模型诱导了局部分类器的训练。Step 3和4的收敛速度非常快,总共只需要10多轮。

4.4 论RRP

跳过Alg.1的Step 1,训练也可以收敛。在这种情况下,训练将类似于PAR [37],其采用注意机制来对齐局部,如第2节中所介绍的。我们在实验中比较这两种方法,即在有或没有步骤1的情况下训练局部分类器,并证明诱导训练很重要。没有诱导训练,性能显着降低。例如,在Market-1501上,当诱导训练时,PCB与RRP相结合,达到80.9%mAP。 当除去诱导训练时,mAP降低至74.6%。这意味着所提出的诱导训练优于PCB上的注意机制。有关详细信息,请参见第5.5节。

五、实验

5.1 数据集和设置

[略]

5.2 实现细节

用于比较的IDE的实现

对原始版本进行了多次优化[40]的ResNet50:

- 在ResNet50中的“pool5”层之后,我们追加一个输出尺寸为256-dim的全连接层,再接Batch Normalization和ReLU;

- 虽然“pool5”层中没有可训练的参数,但有证据表明在其上应用dropout=0.5,输出2048d的高维特征向量,有效避免了过拟合并获得了相当大的改进;

在Market-1501上,我们实现的IDE达到85.3% rank-1 accuracy and 68.5% mAP,这比[45]中的实现略高。

训练

[略]

5.3 效果评估

- PCB is a strong baseline.

- Refined part pooling (RPP) improves PCB especially in mAP.

- The benefit of NOT sharing parameters among identity classifiers. 局部分类器使用独立参数的好处

- 达到最佳:we report mAP = 81.6%, 69.2%, 57.5% and Rank-1 = 93.8%, 83.3% and 63.7% for Market1501, Duke and CUHK03

5.4 参数分析

- 图片尺寸:更大的图像尺寸有益于学习到局部特征, mAP和rank-1准确度都随着图像尺寸的增加而增加,直到达到稳定。

- tensor T 尺寸:较小的下采样率增强了网络能力,尤其是在使用相对小的图像作为输入时。建议在考虑计算效率的情况下将下采样率减半。

- 局部 p 的数量:随着p的增加,检索精度首先会提高之后下降,过度增加p使得有些局部可能会坍塌到空白,损害了局部特征的辨别能力。

5.4 诱导训练和注意力机制

[略]

六、结论

[略]

![[翻译]Pyramid Vision Transformer](https://blog.mclover.cn/wp-content/themes/slanted/img/thumb-medium.png)