ABSTRACT

本文揭示了大型语言模型(LLMs)尽管仅在文本数据上进行训练,但在没有语言的情况下,它们仍然是纯视觉任务的强大编码器。更有趣的是,这可以通过一种简单但以前被忽视的策略实现 – 使用来自预训练LLMs的冻结Transformer块作为组成编码器层,直接处理视觉令牌。我们的工作推动了利用LLMs进行计算机视觉任务的边界,显著偏离通常需要与相关语言提示,输入或输出的多模式视觉语言设置的传统做法。我们证明了我们的方法在各种任务中始终提高性能,包括纯2D和3D视觉识别任务(例如,图像和点云分类),时间建模任务(例如,动作识别),非语义任务(例如,运动预测)和多模式任务(例如,2D / 3D视觉问答和图像文本检索)。这种改进是一种普遍现象,适用于各种类型的LLMs(例如LLaMA和OPT)和不同的LLM Transformer块。我们还提出了信息过滤假设来解释预训练LLMs在视觉编码中的有效性 – 预训练LLM Transformer块识别信息丰富的视觉令牌并进一步放大它们的效果。这个假设在经过LLM Transformer块训练后的特征激活中得到了实证支持,表现出更强的关注相关区域的特征激活。

1 INTRODUCTION

大型语言模型(LLMs)在大量文本数据的训练下,最近展示了在各种任务中的显著潜力,超越了它们最初的语言领域。例如,在计算机视觉领域,LLMs表现出与视觉令牌交互并将它们解码为令牌化输出的能力。这通常是通过将视觉令牌通过线性层(Koh等人,2023; Lin等人,2023; Merullo等人,2023; Schwettmann等人,2023)投影到LLMs中,或者在视觉和语言令牌之间使用交叉注意机制(Alayrac等人,2022; Li等人,2022; 2023; Wang等人,2023)来实现的,作为语言模态的例子。随着我们探索利用LLMs进行计算机视觉任务的极限,一个有趣的问题出现了:LLMs能否有效地处理完全基于视觉的任务,而不依赖于语言?

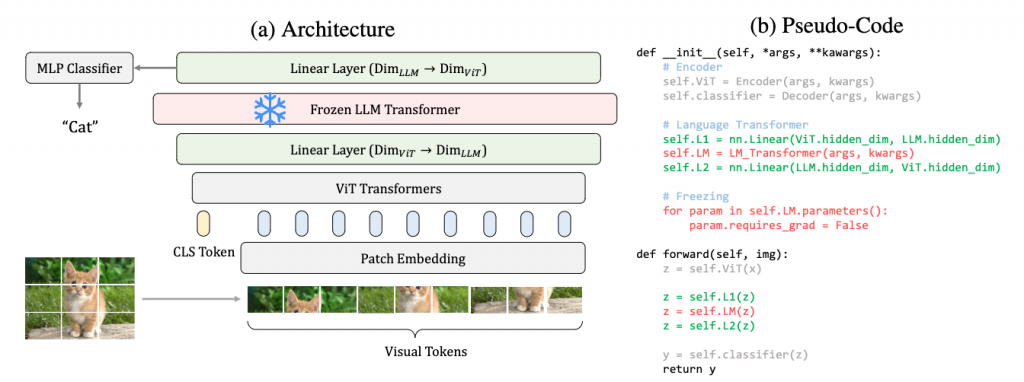

本文提供了一个积极的可行性演示,介绍了一种简单但以前被忽视的方法:将预训练的LLM中的冻结Transformer块作为通用视觉编码器层,直接处理视觉标记。具体而言,如图1a和图1b所示,我们的设计包括以下步骤:(1)提取冻结的LLM Transformer块并将其附加在原始视觉编码器之上;(2)在添加的LLM块之前和之后插入可训练的线性层以对齐特征维度;(3)在训练期间像往常一样优化其他模块时冻结LLMTransformer。

令人惊讶的是,这种简单的设计可以提高各种任务的性能,包括2D和3D识别(图像和点云分类)、视频理解(动作识别)和非语义(运动预测)任务。除了这些纯视觉任务外,我们的方法在多模态任务(2D/3D视觉问答和图像-文本检索)中也非常有效。值得注意的是,这种改进在各种类型的LLM(如Touvron等人的LLaMA(2023)和Zhang等人的OPT(2022))以及不同的LLM Transformer块中都是普遍的。

我们发现使用预训练的LLM transformer块作为视觉编码器层是有趣的,因为它显著偏离了视觉语言模型(VLM)的传统设计。特别是,我们将LLM transformer视为编码器(1)独立于语言提示、输入或输出运作;(2)允许从头开始训练,无需像CLIP(Radford等人,2021)这样的预训练骨干;以及(3)将LLM的使用解耦并简化为单独的transformer块。

然而,一个关键问题仍然存在:为什么LLM在视觉编码方面有效,考虑到它们仅在文本上进行了训练,从未遇到过视觉数据?为此,我们提出了信息过滤假设:预训练的LLM transformer块识别信息丰富的视觉标记,并进一步增强它们对潜在表示的贡献。这个假设源于我们在多个任务中的观察,其中特征激活在整合冻结的LLM transformer块后始终展现出更强的关注相关区域的焦点。

总之,我们做出了以下贡献:

- 我们发现使用预训练LLMs的冻结Transformer块作为视觉编码器层,通过引入一种简单但未被充分利用的方法,可以促进各种任务的多样性。

- 通过我们对各种LLMs和transformer 块的调查,我们证明了冻结LLM Transformer在视觉编码中的好处是一种普遍现象。

- 我们提出了信息过滤假设来解释冻结LLM Transformer在处理视觉令牌时的有效性:合并的LLM块区分信息丰富的令牌并放大它们的效果。

我们希望我们的工作能够引起人们对使用LLM Transformer作为通用编码器的有趣应用的关注,不仅适用于视觉输入,还可能适用于其他模态。此外,我们希望激发对理解LLMs / VLMs的新视角的启示。

3 METHOD: FROZEN LLM TRANSFORMER FOR VISUAL ENCODING

与视觉语言模型的比较 我们的方法乍一看似乎与最近的视觉语言模型(VLMs)相似,例如Lin等人(2023年)、FROMAGe(Koh等人,2023年)和LiMBeR(Merullo等人,2023年),其中线性层直接将视觉特征投影到LLMs的输入空间中。然而,我们的方法是不同的,因为线性层F1L不一定将视觉表示z对齐到语言空间中。具体而言,这体现在三个方面:(1)视觉预训练的独立性。我们的范例支持从头开始训练,不依赖于像CLIP(Radford等人,2021年)这样的预训练视觉编码器。(2)语言的独立性。我们的框架可以在没有基于语言的输入或提示的情况下运行,并且它适用于一般的视觉表示学习,而不仅仅是视觉语言任务。(3)转换块的独立性。以前的VM将LLM视为一个连贯的模块,而我们的框架将每个Transformer块分离为一个独立的视觉编码层。

与LLMs的比较。由于视觉和文本数据之间的不同格式,我们大大改变了LLM Transformer的行为。 (1)注意力掩码。LLMs通常利用自回归掩码来模拟文本生成的顺序。然而,视觉数据中的标记一次性出现,例如猫的图像标记(图1a)。因此,我们放弃自回归注意力掩码,仅使用注意力掩码来指示填充标记。 (2)位置嵌入。LLMs中的位置嵌入,例如LLaMA中的旋转位置嵌入(Su等,2021),不是视觉编码器的常见选项。因此,我们为简单起见和与原始视觉骨干的一致性而删除LLMs的位置嵌入。考虑到Transformer 中注意力掩码和位置嵌入的重要性,令人惊讶的是,我们的框架对视觉任务仍然产生了积极影响。

4 APPLICABILITY OF LLM TRANSFORMERS FOR VISUAL TASKS

我们将我们的框架实例化到各种任务中,并观察预训练LLM转换器的广泛适用性。我们的实验涵盖了2D(图像分类)和3D(点云分类),单帧和多帧(动作识别),语义和运动(运动预测),以及涉及语言输入或不涉及语言输入的2D和3D视觉语言任务。默认情况下,我们采用LLaMA-7B(Touvron等人,2023)的最后一个Transformer块。我们的框架在这些任务中遵循先前工作的标准,实现了一致且显著的改进。有关我们设计的更多分析,请参见第5节。

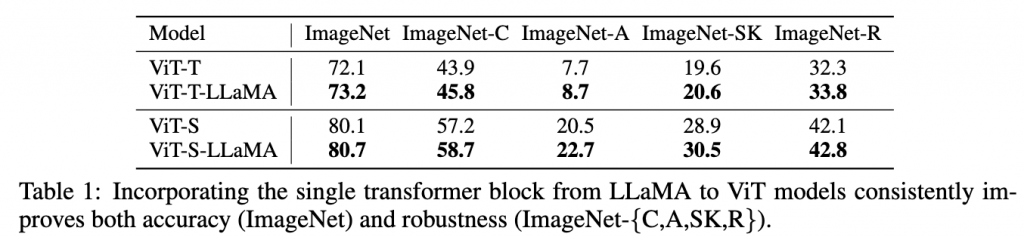

4.1 IMAGE CLASSIFICATION

任务说明 我们在ImageNet1k(Deng等人,2009)上进行准确性实验,并额外评估鲁棒性:来自ImageNet-C(Hendrycks&Dietterich,2018)的损坏图像,来自ImageNet-A(Hendrycks等人,2021b)的自然对抗图像,以及来自ImageNet-SK(Wang等人,2019)和ImageNet-R(Hendrycks等人,2021a)的超出分布的图像。

实验设计 由于其广泛使用和对transformer的原始支持我们选择ViT结构(Dosovitskiy等人,2021)。根据方程式2中的符号,编码器FE是ViT中的自我注意 transformer 块集,解码器FD是线性分类器。 LLaMA Transformer插入在编码器和解码器之间,如图1a所示。我们遵循DeiT(Touvron等人,2021)的相同配置,从头开始训练基线ViT模型和ViT-LLaMA。有关实现详细信息,请参阅第C.1节。

结果分析 在表1中,包括对干净ImageNet图像,受损、对抗和超出分布图像的准确性,ViT模型的准确性在合并冻结的LLaMA Transformer块后持续提高。我们的进一步实验验证了改进与LLM Transformer密切相关,而不是仅仅增加模型容量的结果。有关实现详细信息,请参阅第5.1节。我们也在第6节中进一步解释了收益来源的信息过滤假设。

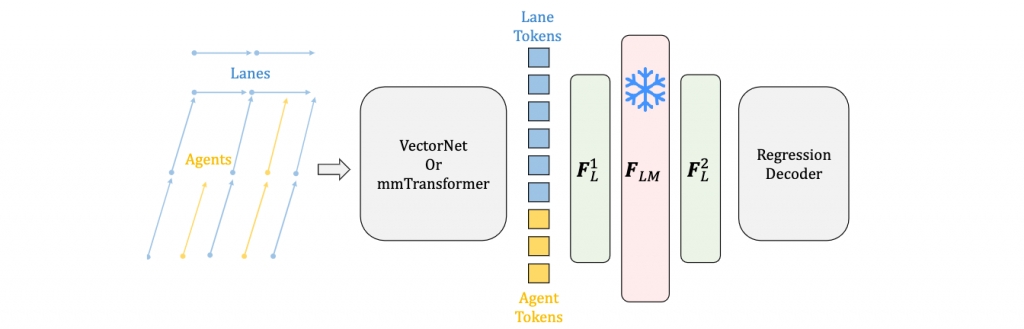

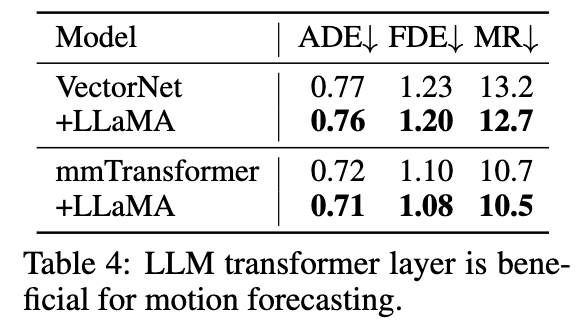

4.4 MOTION FORECASTING

任务说明 我们选择运动预测作为非语义任务的例子。这对于自动驾驶来说是安全关键的,并且利用了动力学、代理-代理交互和代理-车道关系的理解。输入通常包括代理的历史轨迹和车道段的路标,两者都在鸟瞰图上用折线表示。期望的输出是一组K个最可能的未来轨迹,其中多个未来设置明确考虑了城市交通的不确定性。我们在Argoverse上进行实验(Chang et al.,2019),评估指标为最小平均位移(ADE)、最小最终位移(FDE)、脱靶率(MR),分别从不同方面计算预测的误差,在较低值时更好。

实验设计 我们将冻结的LLM transformer 应用于VectorNet(Gao等人,2020)和mmTransformer(Liu等人,2021)。这两个模型首先将代理和车道的折线转换为令牌嵌入,并且它们的编码器利用一系列注意块来处理这些代理和车道令牌。我们的LLaMA transformer 块位于它们的编码器后面,并在将目标代理的特征馈送到解码器之前处理这些代理和车道令牌。

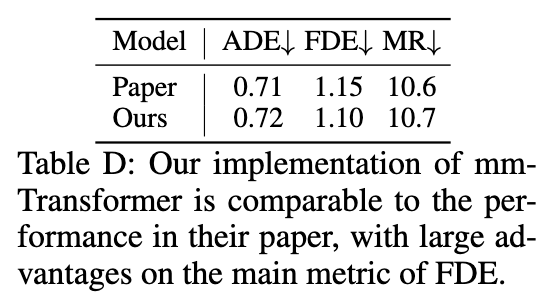

由于运动预测在计算机视觉中不是很常见的任务,我们直观地在图G中展示了它的问题设置和模块化架构,其中VectorNet(Gao等人,2020)和mmTransformer(Liu等人,2021)将每条车道或代理轨迹编码为令牌嵌入,然后我们的LLM块处理这些令牌并将它们馈送到回归解码器中。由于 VectorNet 和mmTransformer 没有发布他们的训练代码,我们在自己的代码上重现了他们的结果,并取得了比论文中报告的更好或类似的结果。正如表C和表D中所示,我们论文中使用的基线(表4)与论文中的原始性能相当甚至更好,这对于公正和有意义的比较至关重要。

在训练期间,我们分别训练VectorNet或mmTransformer。VectorNet是一个相对简单的架构,因此它的训练持续60个时期,采用余弦退火学习率调度(Loshchilov&Hutter,2016)。我们使用AdamW优化器(Kingma&Ba,2014; Loshchilov&Hutter,2017),学习率为5e-4,批量大小为32个样本。对于mmTransformer,我们使用与VectorNet相同的学习率,批量大小和优化器进行训练。训练持续32个时期,在第20、24和28个时期上将学习率降低1/4。这两个模型的训练时间约为1个A100 GPU的2天。

结果分析 根据表4,具有LLaMA的模型预测出更好的轨迹,这反映在与地面真实值的距离较小。然而,我们注意到与语义任务相比,改进不太显着,这反映了LLM transformer对编码丰富的语义优于抽象对象运动的偏好。

4.5 VISION-LANGUAGE TASKS

4.5.1 2D VISION-LANGUAGE TASKS

任务说明 我们在2D视觉语言(VL)任务中进行了实验,包括在VQAv2(Goyal等人,2017c)上进行视觉问答(VQA)和在Flickr30k(Plummer等人,2015)上进行零样本图像检索。在这两个任务中,模型的输入包括图像和文本。因此,它们评估了冻结语言变换器将多模态视觉语言特征融合用于下游任务的能力。

实验设计 我们采用广泛使用的METER(Dou等人,2022)作为基线。它首先提取图像和文本的单模特征,然后融合跨模特征,最后从跨模特征解码输出。与将LLM Transformer 块放置在解码器之前的先前设计类似,我们将冻结变换器插入到METER的跨模特融合和解码器模块之间,即METER的编码器末端。

在图H中,我们直观地说明了METER的模块化设计以及插入我们的冻结LLM transformer和线性层的特殊位置。 传统上,METER遵循两阶段的训练策略:(1)在包括COCO Lin等(2014)、概念字幕(Sharma等人,2018)、SBU字幕(Ordonez等人,2011)和视觉基因组(Krishna等人,2017)在内的大量视觉语言数据集上预训练整个视觉语言模型(VLM);(2)在视觉问答(VQA)或图像文本检索等下游任务上进行微调。然而,预训练的第一步计算量巨大,因此我们采用Shi等人(2023)的设置,跳过预训练步骤,直接在目标任务上进行训练。具体而言,我们从CLIP-B/32(Radford等人,2021)初始化图像编码器和从RoBERTa(Liu等人,2019)初始化文本编码器,然后联合微调除了LLM transformer以外的所有模块。由于来自CLIP和RoBERTa的初始化,我们的模型能够合理地进行预测。 在训练阶段,我们严格遵循METER提供的VQAv2(Goyal等人,2017c)和Flickr30k(Plummer等人,2015)上的相同超参数和配置。最关键的细节是METER为每个模块分配不同的学习率。例如,跨模态融合模块和解码器的学习率比预训练的图像和文本编码器的学习率更高。类似地,我们的实验将线性层(F1L和F2L)的学习率设置为图像编码器的学习率的10倍,因为它们是随机初始化的。最后,每个VQAv2和Flickr30k的训练持续10 epochs,在4×A100 GPU上大约需要1天的时间。

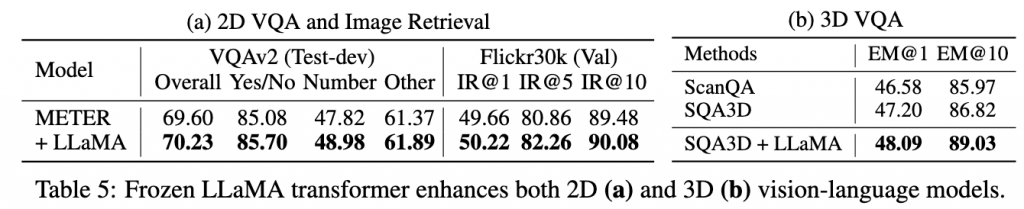

结果分析 如表5a所示,LLaMA变换器显著增强了两个2D VL任务,包括在VQAv2上的问答质量和在Flickr30k上的检索召回率的提高。这一证据支持使用冻结LLM transformer对多模态特征进行编码的潜力。

4.5.2 3D VISUAL QUESTION ANSWERING

任务说明 我们将我们提出的想法扩展到3D VQA,这需要理解由点云或多视图图像表示的输入3D场景,然后回答问题。 3D VQA挑战了在3D上下文中将语言与实际情境联系起来的能力,其中模型需要理解点云形式的三维视觉上下文与语言上下文的协同作用。我们在SQA3D(Ma等人,2023)数据集上进行实验,与基线方法和最新技术(Ma等人,2023; Azuma等人,2022)在精确匹配(EM)指标上进行比较。

实验设计 与2D VL模型类似,SQA3D的基线也采用了单模编码和多模特征融合的模块化设计,然后解码输出。它使用LSTM(Hochreiter&Schmidhuber,1997)处理文本输入和VoteNet(Qi等人,2019)处理3D点云,然后进行VL融合,再送入解码器。在这里,我们在VL融合后添加了冻结的LLM块,这与我们的2D VL设计一致。

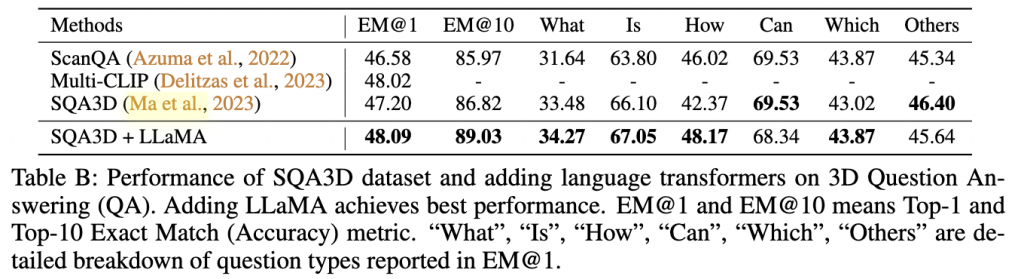

结果分析 根据表5b,添加冻结的LLM transformer有效增强了模型融合点云和语言特征并为3D问题回答打下基础的能力。我们在表B中进一步提供了详细的细分指标,其中添加LLM transformer对大多数情况都有益。

5 消融实验

5.1 ABLATION STUDY ON DESIGN CHOICES

模型能力

我们质疑改进主要来自于线性层F1L和F2L的增加容量,而不是LLM的预训练权重。为了分析模型容量,我们创建了ViT-S-MLP,它与ViT-S-LLaMA具有相同的可训练参数。具体来说,ViT-S-MLP删除了LLM块,然后在F1L和F2L之间插入了GeLU激活(Hendrycks&Gimpel,2016)和层归一化(Ba等人,2016)。它还采用了与第4.1节中的ViT和ViT-LLaMA相同的训练过程,以进行公平比较。结果总结在表6中:由于其增加的容量,ViT-S-MLP的性能优于ViT-S,但改进仅为ViT-S-LLaMA的一半。因此,LLM Transformer权重对于改进至关重要,观察到的好处不仅仅是增加模型容量的结果。

Finetuning

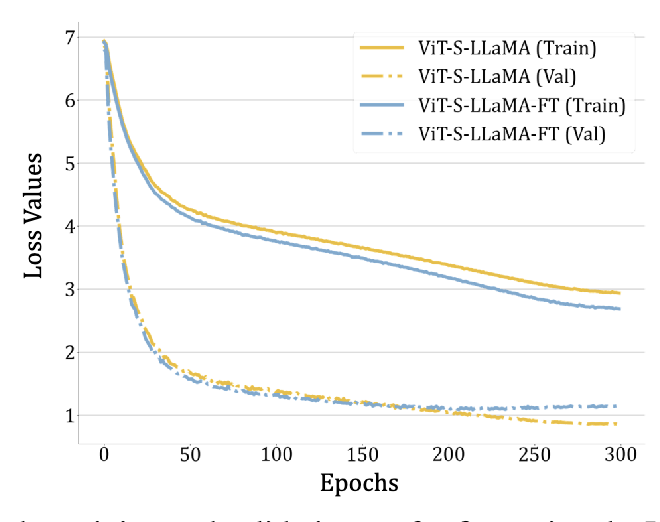

我们进一步验证了微调语言变换器(ViT-S-LLaMA-FT)是否比冻结它更好。如表6所示,与ViT-S-LLaMA相比,微调会降低性能。我们通过在图F中可视化损失曲线并在100个时期的额外设置下进行训练来分析这种现象。尽管微调可以在短时间训练(表A中的100个时期)下提高性能,但在充分训练时会降低准确性:在图F中,ViT-S-LLaMA-FT显示出较低的训练损失但相对较大的验证损失,这表明出现了过拟合。因此,我们的观察结果展示了训练大型变换器的挑战,并因其简单和有效而冻结了我们设计中的LLM变换器。

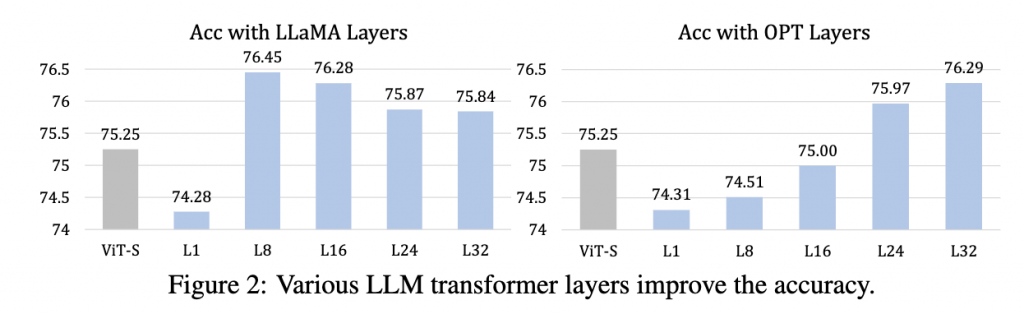

5.2 VARYING LLM TRANSFORMER LAYERS

我们发现,在我们的框架下,即使它们具有相同的容量,LLM transformer也会显着影响视觉表示学习。具体来说,我们使用来自LLaMA-7B(Touvron等人,2023)和OPT(Zhang等人,2022)的不同深度的Transformer 块到ViT-S。这些模型在100个时期的消融研究设置中进行训练。如图2所示,层的类型显着改变了性能。这些实验还验证了我们的框架适用于各种LLM和Transformer层,并强调选择适当的Transformer层的重要性。我们还观察到,尽管它们可能不是最佳的,但最后的LLM层始终改善了性能。

5.3 VARYING LLM TRANSFORMER SCALES

本节分析了使用OPT(Zhang等人,2022)的语言变换器的规模对其影响。我们的实验将OPT-{125M,350M,1.3B,2.7B,6.7B}的最终Transformer层集成到ViT-S中进行图像分类。我们的实验设置基于DeiT(Touvron等人,2021),并进行了100个时期的训练。此外,我们使用小规模OPT(OPT-{125M,350M})进行实验时,即使使用原始的DeiT学习率进行训练,也会产生nan的损失值,因此我们将它们的学习率降低1/5以进行稳定的训练。这间接反映了LLMs规模的重要性。 如表7中的结果所示,冻结语言变换器的好处随着OPT Transformer 容量的增加而增加。只有在足够大的规模(1.3B,2.7B,6.7B)下,添加Transformer 才会增强性能,而当规模较小(125M,350M)时,会降低准确性。因此,LLM变换器增强视觉任务的现象只有在足够的规模下才会“出现”。

6 INFORMATION FILTERING HYPOTHESIS

信息过滤假设 预训练的LLM Transformer 作为“过滤器”发挥作用,区分信息标记并放大它们对预测的贡献,以特征激活中的放大幅度或频率的形式。我们首先在图像分类的背景下推导出这个假设(第6.1节),然后提供定量调查(第6.2节)并讨论其他任务的观察结果(第6.3节)。最后,我们讨论与可用信息的联系以及讨论限制(第6.4节),并在第A节中包含更多细节。

6.1 信息过滤假设的定性推导

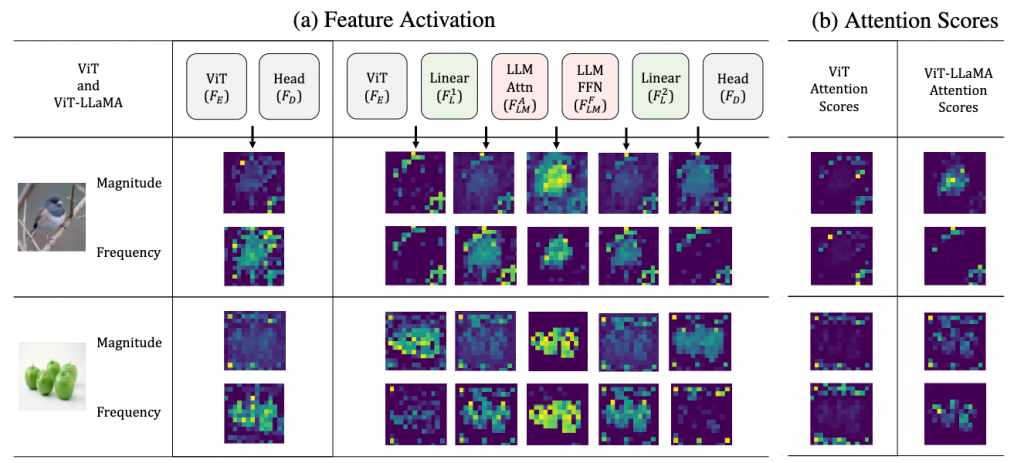

有意义信息标记的显著集中 我们的假设源于在增加预训练LLM Transformer后特征激活高亮展示了有意义的信息标记。在分析中,我们提取每个层后的特征激活信息,如图3a所示,包括原始ViT FE、LLM中的注意力层FALM和前馈网络FFLM,以及线性层F1L和F2L。值得注意的是,特征激活是根据幅度(中心化后的L2范数)和频率(傅里叶变换后的角度的L2范数)计算的。图3a中的不同层确实显示出对幅度或频率的不同偏好。正如图3a清楚地展示的那样,在添加LLM transformer后,标记激活更好地捕捉到目标对象的区域,特别是F2L的幅度和FALM的频率。它们的分割倾向是一个令人惊讶的发现,因为自主分割仅存在于自监督学习(Caron等人,2021)或特别设计的(Shi等人,2023)ViTs中。更重要的是,对目标对象的显著集中直接支持我们的假设,作为选择信息标记的证据。

嘈杂的注意力分数 与特征激活相比,注意力分数很难捕捉到预测所需的相关视觉标记。我们调查了CLS标记和最后一个transformer块中的视觉标记之间的注意力分数,分别是ViT在FE中的最后一个自我注意块和ViT-LLaMA的transformer块FLM。理想的注意力分数应该展现出像DINO(Caron等人,2021)那样的目标对象分割模式。然而有监督的 ViT 模型通常具有嘈杂的注意力分数(图 3b 左侧)。尽管 ViT-LLaMA 展示了一些注意力头中偶尔有分割能力,但大多数注意力分数也受到散射和嘈杂的影响。这些观察结果与特征激活相矛盾,并表明 LLM transformer 的好处不能简单地归因于注意力分数,因为注意力分数无法可靠地贡献正确的视觉标记。

推导信息标记的放大 根据我们在图3a中的可视化,冻结的LLM transformer区分信息标记。直观地说,这些标记自然有助于下游解码,但仅当解码器直接将视觉标记作为输入时才是直接的。作为反例,ViT利用CLS标记进行分类,由F2L输出的视觉标记不是解码器的输入,在训练期间始终接收零梯度。为了弥合CLS标记场景中的差距,我们假设的后半部分是必要的:冻结的LLM transformer放大了信息标记的贡献。

[略]

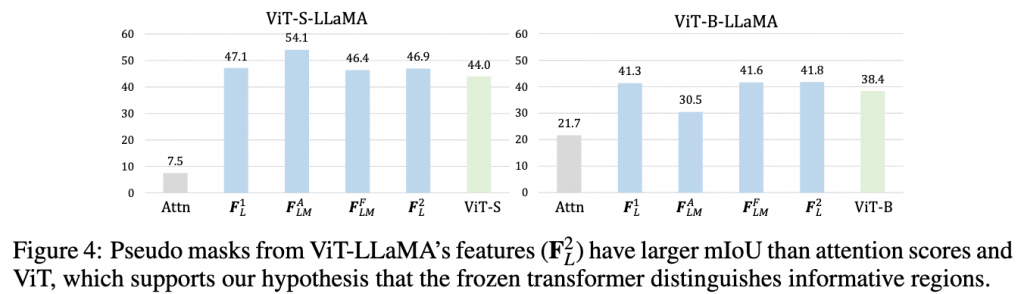

6.2 定量证据

第6节中的定性观察得到了定量证据的进一步支持。具体而言,我们使用ImageNet-S(Gao等人,2022)数据集,通过其语义分割掩模的注释提供“信息区域”的基本事实。为了评估特征激活和注意力分数的保真度,我们首先生成伪掩模,突出它们的集中区域,即在同一图像上比其他标记具有更大激活或注意力分数的标记。然后,特征和注意力分数的质量通过它们的伪掩模和基本事实分割掩模之间的mIoU(平均交集比)来反映。实现细节在A.3节中。

最后,我们总结了特征激活和注意力分数的mIoU统计数据,如图4所示。正如所示,ViT-S-LLaMA和ViT-B-LLaMA的伪掩模的mIoU都比注意力分数更好。这直接支持我们的假设,即特征{z2 L [v])| v∈V}比注意力分数{wv | v∈V}更可靠。我们还注意到,与ViT相比,ViT-LLaMA的伪掩模通常具有更大的mIoU,这反映了使用冻结的LLM transformer 训练ViTs的好处。第一线性层F1 L的特征优势也揭示了使用我们的框架对更早阶段的特征有益。但是,我们想澄清的是,无论是幅度还是频率激活的伪掩模都是直观但有损的度量特征质量的方法,因为神经网络可以将信息编码为其他格式。因此,开发更好的测量方法来分析单个网络层将对未来的工作具有意义。

6.3 INFORMATION FILTERING HYPOTHESIS ON OTHER TASKS

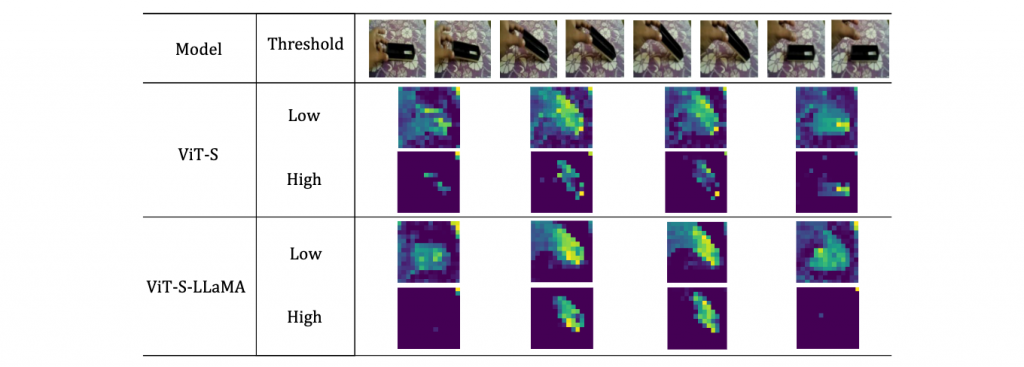

前面的章节主要讨论了我们关于图像分类的信息过滤假设。同时,我们还在各种其他任务中发现了支持我们假设的证据。由于空间限制,本节以动作识别为例进行研究,而第A.2节则涵盖了其他任务,包括点云分类、2D VQA和3D VQA。我们主要从定性的角度分析信息过滤假设在动作识别中的作用,因为对于这个任务,“相关区域”的真实值很难量化。在实践中,我们遵循类似于第6.1节的程序,并在图5中可视化视频令牌的激活情况。在低激活阈值下,我们注意到来自ViT-S-LLaMA的视频令牌比ViT-S更好地捕捉手和操作对象的前景区域。通过同时在空间和时间上激活VideoMAE中的视频令牌,我们进一步增加了阈值,以展示其选择信息帧的能力。如图5中的“高阈值”行所示,ViT-S-LLaMA更准确地聚焦于具有实际人物-物体交互的中间帧。因此,我们得出结论,信息丰富的视频令牌在动作识别中确实是有区别的,并且符合信息过滤假设。

6.4 讨论和假设的限制

可用信息的角度 我们补充了徐等人(2020)的观点,这极大地激发了我们对信息过滤假设的研究。徐等人(2020)提出,经过良好训练的神经网络层可以被视为一种解密器,将可用信息添加到特征中,并使后续模块更好地推断潜在信息。在我们的信息过滤假设中,合并的模块确实充当解密器,扩大可用令牌的贡献,并有利于下游预测。

限制 尽管我们的信息过滤假设解释了如何通过冻结LLM transformer来提高性能,但我们注意到还有一些有趣的现象尚未涵盖。首先,当前的假设无法分析不同层的效用。其次,该假设未解释训练动态如何促进视觉令牌特征与冻结语言变换器合作,这是有趣的未来工作。

7 CONCLUSIONS

讨论和限制 我们已经验证了预训练、冻结的语言转换器在广泛的视觉任务中的能力。需要注意的是,我们的目标是系统地探索这个未被充分研究的问题。因此,我们的实验旨在在公平比较中最大化任务的多样性,与已经建立或有竞争力的基线相比,而不是为所有任务争取最先进的性能,这也受到我们的计算资源的限制。我们将实验扩展到所有任务的最先进水平作为有趣的未来工作。同时,我们也注意到我们的信息过滤假设没有涵盖一些有趣的问题,例如如何量化不同层的功能,分析训练过程如何促进视觉令牌特征与语言转换器合作,这也是有意义的方向。

结论 在这项工作中,我们探索了大型语言模型(LLMs)作为视觉任务编码器的意外能力,这是与它们传统的基于文本的应用的显著分离。通过将预训练LLMs的冻结转换器块无缝集成到视觉编码器中,我们观察到在2D图像和视频分类、3D点云识别、非语义运动预测以及2D和3D视觉语言任务等各种视觉挑战中都有一致的性能提升。这种现象,以我们提出的信息过滤假设为基础,突显了LLMs的内在适应性和多功能性,可用于更一般的表示学习。我们希望我们的见解能够催生对LLMs应用领域的进一步探索,并促进利用它们的潜力的创新策略。

![[翻译]AN IMAGE IS WORTH 16X16 WORDS: TRANSFORMERS FOR IMAGE RECOGNITION AT SCALE](https://blog.mclover.cn/wp-content/themes/slanted/img/thumb-medium.png)