https://arxiv.org/pdf/2406.18665

Abstract

大型语言模型(LLM)在广泛任务上表现出色,但选择合适的模型往往需要在性能与成本之间权衡。强大的模型效果更好却更昂贵,小型模型更具成本优势但能力较弱。为解决这一权衡,我们提出一种训练框架,用于学习高效的“路由器”模型,在推理过程中动态选择更强或更弱的 LLM。我们的框架利用人类偏好数据,并采用数据增强技术来提升性能。在公共基准上的评估表明,该方法在不牺牲响应质量的前提下可将成本降低超过 2 倍。此外,我们的路由器具有很强的泛化能力,即使在路由至未参与训练的 LLM 之间也能保持性能。这凸显了该框架在提供高性价比且高性能的 LLM 解决方案方面的潜力。

Metric

在本节中,我们定义用于刻画 LLM 路由问题中成本与性能权衡的评估指标。我们首先给出分别评估路由器模型 MRα 在两种模型(Ms ∈ Mstrong 与 Mw ∈ Mweak)之间路由时的成本效率与性能的指标,然后引入在实验评估中使用的两个复合指标。

通过计算路由至强模型的调用比例来衡量 MRα 的成本效率:

c(MRα) = (1 / |Q|) ∑{q∈Q} I{Rα(q) = Mstrong}

因为强模型 Mstrong 的调用成本显著高于弱模型 Mweak。

通过计算平均响应质量来衡量性能:

r(MRα) = (1 / |Q|) ∑{q∈Q} s(MRα(q))

其中 s(MRα(q)) 表示单条响应的质量分数,例如在带金标的数据集(如 MMLU)上的正确率,或数值打分(如 1-5 或 1-10),数值越高表示质量越好。类似地,可分别定义强模型与弱模型的 r(Ms) 与 r(Mw)。 由于路由器模型的性能位于弱模型与强模型之间,我们将其性能相对于两者之间的差距进行量化。

性能差距回收率(PGR):PGR(MRα) = [ r(MRα) − r(Mw) ] / [ r(Ms) − r(Mw) ]

该指标刻画了路由器模型从弱模型到强模型之间的性能差距中,能够“回收”多少。 单独使用上述任一指标都不足以刻画路由中的质量—成本权衡。例如,一个总是把所有请求发送到强模型的“平凡”路由器可以达到完美的 PGR = 1,但没有任何成本节约。为解决这一问题,我们通过改变阈值 α,为路由器 MRα 计算“调用—性能”曲线。

平均性能差距回收率(APGR):APGR(MRα) = ∫₀¹ PGR(MRα) d(c(MRα))

作为在不同成本约束下路由器回收性能差距能力的总体度量

调用—性能阈值(CPT):在给定期望的路由器性能(即达到 x% 的 PGR)时,CPT(x%) 表示为达到该目标 PGR 所需调用强模型的最小比例。

Method

相似度加权(SW)排序:采用 Bradley–Terry(BT)模型,给定用户查询 q,我们计算它与训练集中每个查询 q′ 的余弦相似度,并按该数据集中 q′ 的最大余弦相似度进行缩放

矩阵分解:借鉴推荐系统中的矩阵分解模型,我们将该方法用于从偏好数据中学习。目标是发现隐藏评分函数 δ : M × Q → R,其中 δ(M, q) 表示模型 M 对查询 q 的响应质量。用 S 形函数 σ 建模胜出概率,并在偏好数据上进行优化。

BERT 分类器:使用 BERTBASE 架构获取用户查询的上下文化嵌入,输出分类。

Causal LLM 分类器:用 Llama 3 8B对路由器进行参数化,将包含用户查询的指令提示作为输入,将比较标签作为额外的词表 token,以 next token 的方式直接输出胜出概率。

Performance

综合性与开放性:MT-Bench > MMLU ≈ GSM8K,MT-Bench更贴近真实对话,维度多且主观性强。

知识要求:MMLU > MT-Bench ≈ GSM8K,MMLU覆盖面广、专业性强。

纯推理与步骤稳定性:GSM8K > MMLU > MT-Bench,GSM8K强调链式推理与稳健计算。

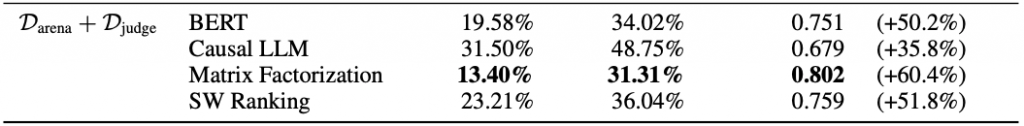

MT-Bench

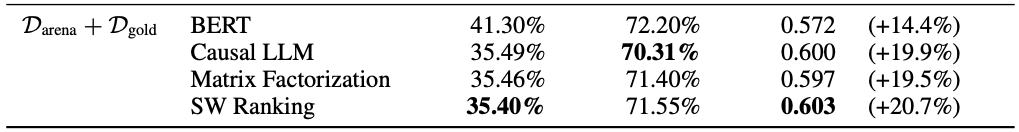

MMLU

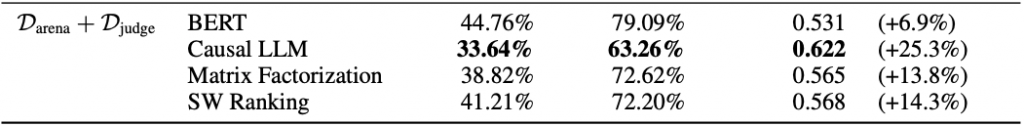

GSM8K

Conclusion

我们在多种基准上展示了路由器的强劲表现,这些基准涵盖了开放式问答、人文与数学问题。通过在强模型与弱模型之间智能路由查询,我们的路由器在不显著增加成本或时延开销的前提下,实现了显著的成本节约与高质量响应。我们还显示,即便在多个不同的强/弱模型组合之间切换,路由器无需再训练也能保持性能——如果缺少这一能力,实用性将大打折扣。

我们的结果强调了数据集增强在提升路由器性能方面的有效性。仅在 Darena 上训练会导致在 MMLU 与 GSM8K 上表现不佳,而通过引入 LLM 评审或域内数据对训练集进行增强,则可使路由器在所有基准上优于随机基线。最大幅度的性能提升往往发生在训练数据与评测数据更为相似的情况下,这一点由“基准—数据集相似度分数”所指示。我们认为该框架为在特定应用场景中改进路由性能提供了一条清晰路径。

尽管我们的工作取得了强有力的结果,但仍存在若干限制。首先,虽然我们在多样化的基准上进行了评估,真实世界应用的分布可能与这些基准有显著差异。为此,我们展示了用户可以通过收集少量域内数据并进行数据集增强,来改善特定用例的性能。其次,尽管本文聚焦于“两模型路由”设定,未来一个有前景的方向是将该方法扩展到多模型场景。最后,与其寻求一个适用于所有查询的“单一最佳路由器”,不如从整体上基于时延与成本需求,以及所处理的查询类型来选择路由器。在我们的实验中,我们观察到在同一数据集上训练的不同路由器,在同一基准上的性能可能存在较大差异,且尚无明确解释——对此我们将留待未来进一步研究。

![[转载]ZLPR: A NOVEL LOSS FOR MULTI-LABEL CLASSIFICATION](https://blog.mclover.cn/wp-content/themes/slanted/img/thumb-medium.png)